Poniamo il problema di avere tanti siti web che devono essere segnalati a Google.

Uno dei passi necessari, oltre la normale segnalazione, è quello di inserire le sitemap di questi siti nel pannello di controllo messo a disposizione da Google stessa tra gli ‘strumenti per il webmaster’.

Mettiamo, però, che questi siti non abbiano plugin/script efficienti come quello per WordPress che, ad ogni inserimento di un nuovo contenuto, ricrea la sitemap e pinga i principali servizi di ricezione ping.

La soluzione è o la creazione manuale attraverso applicazioni online o GSiteCrawler

Questo è un programma desktop, gratuito e completo, che crea la sitemap in formato xml e può anche effettuare direttamente l’upload della stessa nella root del sito.

Diamo un’occhiata al programma.

Per cominciare un nuovo progetto clicchiamo su “Add new project”

Così facendo daremo il via alla procedura guidata.

Dopo la prima schermata di presentazione

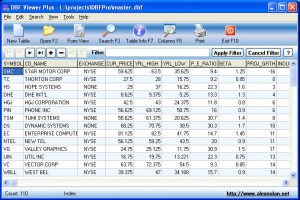

Cominciamo a lavorare inserendo l’URL del sito che dobbiamo analizzare. Automaticamente il progetto prenderà il nome dall’URL, ma potremmo dargli qualsiasi altro nome. In basso a sinistra possiamo notare la scritta “Skip server check?”. Se flagghiamo evitiamo che il programma controlli l’esistenza del sito (non consigliato).

Dopo il check del server ci viene chiesto che tipi di file inserire nella sitemap. Di default sono già presenti tutti i tipi di file più diffusi.

In qualche caso potremmo voler escludere alcuni tipi di contenuti come video o immagini o, in genere, file che non vogliamo siano indicizzati.

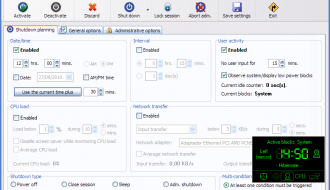

Il terzo step di questa procedura ci richiede se vogliamo utilizzare lo strumento incluso in GSiteCrawler per inviare tramite FTP la sitemap sul server

Nel caso in cui flagghiamo l’opzione, compare il form per l’inserimento dei parametri necessari ad effettuare l’upload ed un tasto per il test della configurazione. In basso ci sono i due tasti che permettono anche la verifica del file, Google o Yahoo!, che ci è servito quando abbiamo dovuto dimostrare di essere i gestori/proprietari del dominio in questione.

L’ultimo step della creazione guidata del progetto è quella in cui abilitamo o meno

- la lettura dell’eventuale file ROBOTS.TXT (il file non viene sovrascritto, casomai viene integrato)

- la ricerca del file personalizzato per la pagina 404 (pagina non trovato – not found)

- l’importazione delle informazioni già immagazzinate da Google

- l’avvio della scansione del sito al termine della procedura guidata

Cliccando su “Finish” comincerà la scansione di tutte le pagine raggiungibili del sito.

Diversi “crawler” lavorano in parallelo per velocizzare l’operazione ma, per siti di grandi dimensioni, potrebbe volerci anche parecchio tempo.

- Laravel + Vue.js vs. Laravel + React.js - 21 Marzo, 2025

- Scopri Autohero: Il Futuro dell’Acquisto di Auto Usate Online - 1 Agosto, 2024

- Guida Completa su Come Usare Satispay - 16 Luglio, 2024